par Hans Zumkeller

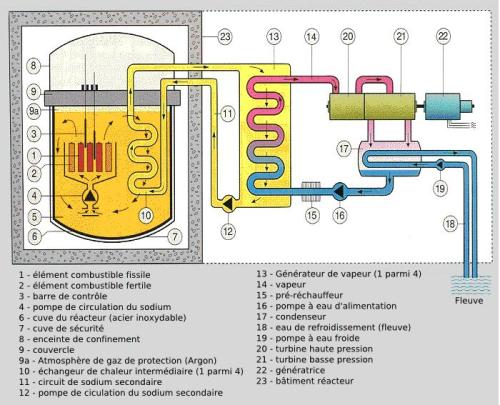

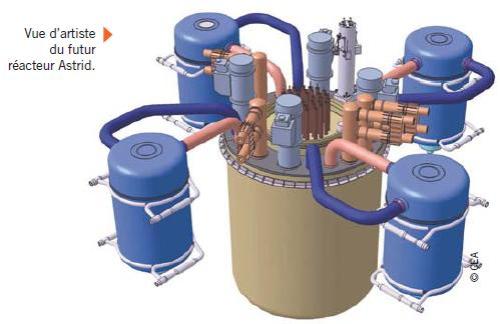

Je me présente. Je travaille depuis longtemps au CEA dans le secteur de la thermique. C’est-à-dire autour de tout ce qui tourne autour de la production de vapeur, des turbines, de leur couplage avec les alternateurs. Mes responsabilités s’étendent également dans le domaine de la sécurité et du refroidissement des coeurs en cas d’arrêt d’urgence. J’ai également participé à des études concernant la circulation du sodium fondu dans les réacteurs à neutrons rapides. J’ai un poste de chef de service. Mais je n’ai pas de responsabilités dans le domaine de la neutronique, de la tenue des matériaux face à leur irradiation, de leur fragilisation, du retraitement, du comportement des nouveaux combustibles, etc. Mes connaissances d’ancien élève d’une des plus prestigieuses Grandes Ecoles françaises font que j’ai a priori plus de moyens pour aborder les problèmes qu’un simple technicien. A la différence de nombreux collègues, ma curiosité foncière fait que j’ai acquis au fil des ans un ensemble de connaissances couvrant pas mal de domaines, même si je ne les couvre pas tous.

Immédiatement, tout le monde comprendra que je ne saurais m’exprimer en dehors de la protection par un pseudonyme. La réaction serait immédiate. Ceci étant, nombre de collègues ont un point de vue identique au mien, ou très voisin, et gardent le silence. Il est rare que nous en parlions entre nous de façon directe. A notre niveau, qui est celui de responsables importants de la filière, je dois convenir que les problèmes sont plutôt évoqués dans notre milieu fermé, à mots couverts ou sous forme de plaisanteries. Prudence exige.

Voici mon point de vue. S’agissant de stockage souterrain il y a deux types de stratégies. Soit on se propose d’entreposer sous terre des éléments qu’on pourrait qualifier de « passifs », comme par exemple de l’amiante, soit il s’agit de déchets « actifs », qu’il s’agisse de déchets issus de l’industrie chimique ou de l’industrie nucléaire. Cette « activité » peut s’entendre sous deux points de vue. Des déchets « actifs » peuvent simplement évoluer. Constitués de « colis » composites, leurs contenus les plus toxiques et dangereux peuvent se trouver libérés, du fait de la dégradation de leur système d’entreposage, ou parce que leur évolution donne naissance à des sous-produits capables de migrer plus facilement. On pense évidemment à l’émission de substances sous forme gazeuse.

Le stockage souterrain, sur le long terme, est toujours dangereux, parce que peu accessible et donc très difficile à contrôler[1]. Un mouvement de terrain, le développement de fissures, l’extension d’un réseau phréatique peut entraîner une pollution irréversible, extrêmement dommageable pour la santé de personnes, sur des superficies considérables[2].

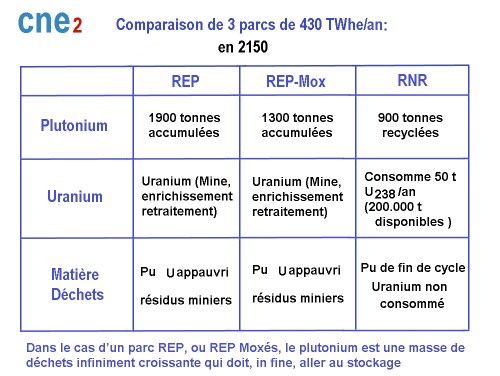

L’entreposage souterrain de déchets nucléaires entre sans équivoque dans la catégorie de la gestion de déchets très actifs. On sait par exemple que les déchets constitués par de la matière plastique se décomposent en produisant de l’hydrogène. Ces molécules, les plus petites qui soient, passent au travers de n’importe quoi. Ca n’est qu’une question de temps. Le danger majeur de l’entreposage envisagé à Bure, dans le cadre du projet CIGEO, est le confinement très important qui y est envisagé. Dans un confinement souterrain émerge immédiatement un problème fondamental. Les liquides conduisent mieux la chaleur que les gaz, et c’est la raison pour laquelle on procède à un pré-stockage des éléments les plus chauds, issus du déchargement de coeurs, dans de l’eau, pendant des années quand le combustible est de l’uranium, temps qui atteindra 50 à 60 années pour le combustible MOX[3], où l’éléments thermogène est le plutonium. Dans les solides, tout mouvement de convexion est par définition impossible et, si on excepte les métaux, ce sont les milieux les moins conducteurs de la chaleur qui soient.

Ainsi toute alvéole, toute galerie contenant des colis dégageant de la chaleur est susceptible de se transformer en four.

Il y a d’ailleurs une sorte de dérision consistant à présenter l’opération ultime de stockage sous la forme d’alvéoles munies d’opercules scellées par des briques de bentonite, laquelle a la propriété de se dilater en absorbant l’eau[4]. Comme si on s’imaginait qu’en logeant des débris à longue durée de vie de cette manière très compacte, on s’en protégerait au maximum. S’agissant de « réversibilité », si la bentonite se dilate en présence d’eau, elle libérera en revanche son contenu aqueux en cas de chauffage intempestif. Ainsi cette idée de scellement durable est-elle sujette à caution. Elle a plutôt été proposée par des gens habitués aux travaux de tunnellerie, où le problème d’un chauffage subit ne se pose évidemment pas, et cette idée a aussitôt été considérée comme providentielle par ceux qui tiennent à ce que ce projet d’enfouissement des déchets nucléaires aboutisse rapidement, coûte que coûte (et « quoi qu’il en coûte » au contribuable).

Selon ce projet de stockage dans une configuration de facto confinée, et n’importe quel ingénieur thermicien le confirmerait immédiatement, le moindre dégagement de chaleur, même s’il ne s’agit pas d’une explosion brutale, transformerait un logement, nécessairement exigu en four.

Dans cette optique, les systèmes de stockage et de confinement envisagés deviennent dérisoires. Le verre, par exemple, donne une image de stabilité, à l’échelle d’âges géologiques. Toutes les mers du monde contiennent des verreries qui ont gardé leurs propriétés et leurs géométries au fil de millénaires. Et cela est encore plus visible quand leur entreposage a été effectué dans de l’air, dans des nécropoles. Ce qui a ainsi « tenu » pendant des milliers d’années semble présenter l’assurance de tenir pendant des dizaines de milliers d’années, voire plus.

Cela se joue ainsi en termes de produit de solubilité. Quand la structure est cristalline, l’assurance de pérennité est encore accrue. Pour reprendre le titre d’un film de James Bond : « les diamants sont éternels[5] ». Des diamants se révéleront inaltérables dans de l’eau de mer, comme « le coeur de l’océan », du film « Titanic ». Il en est de même pour l’inaltérabilité de certains métaux, comme l’or, absolument intacts après des milliers d’années en immersion. Sur le plan chimique, l’or, les diamants sont insolubles dans l’eau, dans les acides et dans les bases.

Mais la stabilité chimique, l’insolubilité ne sont pas les seuls critères à prendre en compte. Bien qu’il soit exclu d’envisager de stocker des déchets dangereux dans des enveloppes de diamant, ou d’or, on trouvera aisément que le diamant brûle à une température dépassant 600 à 800°C. Quant à l’or, il fond à mille degrés, ce qui est une température aisément obtenue dans le four le plus sommaire.

Revenant à la question du stockage des déchets nucléaires, on sait que la longévité des classiques bidons métalliques est de brève durée, vis-à-vis des temps à prendre en compte, au bout desquels leurs contenus peuvent être considérés comme inoffensifs. A terme, ils se corroderont. Et c’est encore pire quand ils sont au contact de l’eau (immersions dans la Manche, stockage dans la mine de sel allemande d’Asse, victime d’une infiltration issue de sa fissuration sous l’effet de contraintes mécaniques, liées au creusement des galeries ).

Ne parlons pas du bitume, qui s’enflamme à 300° et se ramollit au-dessus de 60°. Le béton constitue lui aussi une protection illusoire. Ce composé n’est pas stable. Il ne faut pas oublier que le béton est le produit d’une réaction d’hydratation. Quand il est armé par des tiges de fer, ces armatures internes ne sont pas à l’abri d’une oxydation. L’oxydation entraîne une dilatation des tiges, donc la fragilisation des structures (on parle alors de « cancer du béton »). Quand on pense au stockage souterrain, qu’adviendra-t-il des arceaux de soutènement des très nombreuses galeries, que ceux-ci soient métalliques ou en béton armé ?

Revenant sur la tenue en température, se pose alors la question du conditionnement des déchets à vie longue, les plus dangereux, dans leurs sarcophages de verre. La question du « point de fusion du verre » ne se pose pas, car le verre, amorphe, « non cristallin », n’est pas un solide au sens strict du terme. On a pu lire qu’on avait mesuré un affaissement de certains éléments de vitraux, dus à la gravité. Mais tout cela est lié au mode de fabrication. Le verre possède une certaine viscosité. Mais à la température ordinaire, la géométrie des verres ordinaires n’évolue pas, même à l’échelle de temps géologiques, même sur des milliards d’années. Ce conditionnement, si on vise une dispersion minimale semble donc optimal, s’ajoutant à une très faible solubilité dans l’eau et à une excellente résistance aux attaques chimiques.

Reste son point faible : sa faible tenue thermique.

Le verre se comporte comme un fluide à une température de 1400-1600°C, toujours aisément atteignable dans un four. Par four il faut entendre un dispositif à l’intérieur duquel de la chaleur est dégagée, et ne peut que très difficilement être évacuée vers l’extérieur[6]. La conductivité de l’argilite callovo-orxfordienne est faible.

Les renseignements que l’on peut trouver[7] ne sont pas très abondants, concernant les résultats des expériences concernant la tenue thermique de cet environnement argileux. Par contre, on lit qu’au moment de leur enfouissement les colis dégageront des flux thermiques allant de 200 watts, jusqu’à 500 et 700 watts pour ceux qui contiennent des déchets issus des coeurs ou du retraitement.

C’est absolument énorme.

Dans ce même document, on dit que le contrôle thermique devra être assuré de telle façon que la température de l’argile se maintienne en dessous de 70 à 90°C pour éviter tout remaniement structural, à l’aide d’une ventilation[8]. En d’autres termes le matériau dans lequel on envisage d’opérer cet enfouissement est foncièrement instable vis-à-vis de la température. Or 90° sera une température aisément atteinte si la réfrigération des galeries et même des alvéoles n’est pas assurée pendant un temps suffisant.

Il y a, a priori, deux sources d’échauffement possibles. Celles issues des décompositions radioactives, qui sont calculables et celles, accidentelles, qui découleraient de l’inflammation d’hydrogène dégagé au fil de la décomposition de matières plastiques, qui ne sont ni calculables, ni prédictibles, ne serait-ce que parce qu’on ne dispose pas d’un inventaire précis des contenus de chaque colis scellé.

Revenons à cette question de la tenue thermique des « colis ». C’est là que le bât blesse, ce me semble. Si des containers en verre massif présentent une bonne garantie à la température ordinaire, il n’en est pas de même dès que la température monte de quelques centaines de degrés. Dans une verrerie, on travaille ce matériau à des températures allant de 400 à 600°. Le verre se présente alors sous la forme d’une pâte visqueuse, malléable. A partir de 1400°, c’est un fluide. Ces températures seront aisément atteintes dans une structure confinées et isolée thermiquement, donc dans une alvéole ou galerie.

A propos du béton, sa tenue thermique est également limitée[9]. A une température de 700 à 1000° le béton s’écaille. On dit même « qu’il se pèle comme un oignon ». S’ajoute un phénomène de choc thermo-hydrique, qui fait que le béton « explose littéralement ». On en a des témoignages récents après examens d’incendies dans des tunnels. Lire le très intéressant document cité en référence, illustré par des photos très suggestives[10]. Empressons-nous de préciser que ces dégagements de chaleur, accidentels, ne correspondent qu’à des phénomènes de brève durée.

En règle générale, le béton se décompose chimiquement au delà de 1100° ce qui est une température relativement basse[11]. Il se … déshydrate, tout bêtement et, lorsqu’on s’est livré, au CEA, à des simulations de pénétration d’un « corium » au travers d’un radier de béton ( dont l’épaisseur est de 8 mètres à Fukushima ) les bulles qu’on voyait apparaître à la surface n’étaient autres que de la vapeur d’eau.

Ces considérations rapides font que la conclusion s’impose, vis à vis d’un projet comme CIGEO. Le seul système de stockage tout à la fois actuellement praticable et politiquement responsable est un stockage en surface, qui permet une évacuation illimitée de calories, à un rythme élevé et continu, par convexion, sans risque de surchauffe accidentelle, avec accessibilité garantie.

Le stockage en milieu confiné, qui ne permet d’évacuer cette chaleur, en l’absence de moyens mis en oeuvre avec dépense d’énergie (ventilation), que par conduction est par essence dangereux, surtout quand le dégagement thermique peut s’avérer brutal, lors d’explosions pouvant engendrer des fissurations, la destruction d’un système de ventilation, l’endommagement d’un puits, de galeries d’accès.

Des fissurations résulteront également du creusement de nombreuses galeries, comme cela a été le cas à Asse, en Allemagne[12]. L’argilite a les défauts de ses qualités. C’est un matériau très hétérogène, d’un niveau de cristallinité faible. Cela le dote de faibles qualités mécaniques. Il se désagrège dans l’eau. Son étanchéité n’est ainsi nullement garantie, avec des épaisseurs aussi faibles ( 130 mètres ), situant ce filon entre une couche de calcaire oxfordien en partie supérieure et une couche de calcaire dogger en partie inférieure[13]. Les couches calcaires qui entourent cette fine couche d’argile se prêtent à l’apparition d’une structure karstique. A la moindre pénétration d’eau dans le système de galeries, par le haut, aussi minime que puisse être une fissure, de quelque origine que ce soit, celle-ci donnerait rapidement passage à un flux liquide par phénomène de « puits de Fontis[14] » ( érosion vers le haut ).

En règle générale, la production électronucléaire, outre sa dangerosité et l’impossibilité de démanteler les installations, représente une erreur technologique de notre temps. L’accumulation de déchets ingérables, d’origine nucléaire, s’inscrit dans l’ensemble des activités humaines, dans la mesure où celles-ci se sont résolument écartées de toute idée d’équilibre naturel. Ce n’est que très récemment, dans notre histoire, que l’humanité a forgé l’expression, le label du « bio-dégradable ». Tout ce que produit la nature est par essence bio-dégrable, depuis les excréments, les rejets gazeux, jusqu’aux structures pourrissantes. Les incendies, la respiration des animaux produisent du CO2, qui est recyclé par les plantes. Les tissus animaux ou végétaux sont transformés par des créatures nécrophages, à toutes les échelles. Une infinité de mécanismes sont en place qui débouchent sur une régulation, un équilibre de la biosphère, qui avait fait ses preuves jusqu’à l’apparition de l’homo technologicus.

L’espèce humaine, longtemps négligeable à l’échelle de la planète, génère aujourd’hui des nuisances dans tous les domaines, elle est la source de tous les déséquilibres, et va faire sombrer le navire « Terre » à moins qu’elle n’apprenne au plus vite à se réguler elle-même. Elle réduit, comme le dit Bourguignon, l’agriculture au niveau de la gestion d’une pathologie végétale, l’agriculteur moderne ayant tué toute vie sous la surface du sol qu’il entend exploiter. L’homme, outre la surexploitation qu’il en fait, a empoisonné ses océans, ses rivières, ses lacs et bientôt son atmosphère. Le monde de la consommation et du profit est aussi celui du superflu, du périssable, de l’obsolète, synonymes de gâchis et de mauvaise gestion. En jouant dangereusement avec la génétique l’homme risque d’endommager le patrimoine génétique de la planète, dans tous les règnes, en réduisant comme peau de chagrin un élément régulateur indispensable de la biosphère : sa biodiversité naturelle.

L’homo technologicus est un accumulateur de déchets de longue durée de vie. Les déchets de l’industrie nucléaire ne font qu’étendre la gamme des déchets en tous genres. La caractéristique des déchets nucléaires est leur capacité de dispersion planétaire, par voie aérienne, ou en utilisant poissons et autres animaux comme vecteurs. Une autre caractéristique est leur dangerosité à dose infinitésimale (le plutonium) et leur durée de vie considérable. Aucun agent biologique ou chimique ne peut les dégrader.

L’idée d’entreposer des déchets, dont la durée de vie se chiffrerait en milliers de générations humaines, dans des galeries ajoute le risque d’une contamination de la croûte terrestre, sur des étendues que personne aujourd’hui ne saurait suspecter, du fait des incontrôlables circulations phréatiques; si ce système venait à se développer, comme on peut le craindre s’il est donné suite au projet CIGEO, pour de simples et évidentes raisons de profits et pour enlever des pieds des nucléocrates cette épine appelée « déchets ».

Si la dangerosité des matières nucléaires est à craindre, une solution consisterait non à les placer sous la surface du sol, mais dans des grottes, accessibles, taillées à flancs de falaises, légèrement surélevées pour mettre leur contenu hors d’atteinte d’une inondation, naturellement ventilées et placées sous bonne garde. Il ne pourrait s’agir que d’une façon de gérer les actuels déchets, non d’y stocker des déchets d’une activité nucléaire qu’on entendrait poursuivre. Sur ce plan, bien « qu’étant de la maison » et y ayant fait toute ma carrière (je suis à quelques années de mon départ en retraite) je rejoins totalement l’ex-responsable américain de l’équivalent de l’Autorité de Sûreté Nucléaire française, à savoir Gregory Jaczko, qui fut de 2010 à 2012 responsable du NRC américain (Nuclear Regulatory Commission). Pour lui, comme pour une quantité d’autres, dont je fus, la catastrophe de Fukushima joua un rôle de révélateur. Dans une vidéo[15], il déclare sans ambages :

Enfin il est stupéfiant de voir des scientifiques tabler sur des conditions d’évolution d’un ensemble technologique, sur des durées qui sont des deux ordres de grandeur supérieures à l’âge de notre technologie d’aujourd’hui.

Je rappelle que le Néo-Zélandais Ernest Rutherford découvrit l’atome en 1905, il y a 111 ans à peine.

En un demi-siècle la technologie nucléaire a pris son essor, le prétexte initial étant militaire[16]. En un demi-siècle, avec l’avènement d’un premier plasma de fusion, sur la machine anglaise JET de Culham, les températures de notre technologie ont fait un bon d’un facteur 10’000.

En 2005, dans le laboratoire Sandia, Nouveau Mexique, une température de trois milliards de degrés ayant été obtenue, c’est un nouveau gain de 3 109 / 1,5 108 qui a été obtenu, ce qui correspond à un facteur 20, par rapport aux températures visées dans les machines à fusion. Selon le spécialistes de ces types de compresseurs électromagnétiques, cette température ne serait nullement limitée au sens où, par opposition à la fusion[17] envisagée sur ITER, les instabilités, la turbulence électromagnétiques accroissent la température obtenue en fin de compression, comme la turbulence le fait dans les cylindres de nos automobiles, alors que dans les tokamaks comme ITER cette turbulence, prenant le nom de disruption, fait s’effondrer la température en un millième de seconde.

Non seulement ce nouveau progrès, traduit par cet accroissement des températures ouvre la voie à une fusion directement électrogène aneutronique, ne produisant pas de neutrons et, comme déchet, de l’hélium le plus ordinaire, mais l’obtention de ces ultra-hautes températures débouche sur une technologie nucléaire totalement différente de celle que nous connaissons actuellement. Il ne faut pas oublier, quand on est confronté à des déchets moléculaires toxiques, que les solutions ultimes envisagées impliquent des élévations de température et des modification de la pression, de manière à inciter ces substances toxiques à se muer en espèces plus stable et non toxiques.

La physique nucléaire n’est rien d’autre qu’une chimie des noyaux, dont nous sommes très loin d’avoir fait le tour, un peu comme des primitifs qui, ayant inventé le feu, seraient à mille lieues d’imaginer ce que la chimie pourrait réserver à leurs descendants.

C’est grâce à la catalyse que sont réalisées nombre de synthèses chimiques de notre temps. Ces sont les états métastables qui ont donné naissance au laser. L’électrochimie a donné naissance aux piles, aux accumulateurs, aux techniques électrolytiques. La physique quantique, ignorée au début du siècle dernier, a engendré la supra-condution, la semi-conductivité, et nombre de techniques impensables jusque-là, défiant toute logique. La mise en oeuvre de lois comme celle de Le Chatelier ont permis de diriger des réactions chimiques vers des buts précis. Pourquoi cette « chimie nucléaire » serait-elle moins riche que la chimie dite « minérale » ?

C’est la réelle maîtrise de cette moderne « chimie des noyaux » qui, en mettant en oeuvre des mécanismes qui, à haute température, permettront d’orienter les processus de transmutations, rendront possible de réellement retraiter ces dix millions de tonnes de déchets nucléaires dont nous ne savons que faire, que nos descendants, quand ils sauront maîtriser ces technologies, peut-être dans moins d’un siècle au train où vont les choses, seront alors bien en peine de récupérer, si nous décidons de donner suite à ce projet de stockage profond, qui risquerait de conduire à la plus grande catastrophe environnementale de tous les temps, rigoureusement irrémédiable qui, un jour peut-être sera qualifiée de crime contre la biosphère.

[1] Le concept de “réversibilité”, ajouté au projet CIGEO, fait sourire l’ingénieur que je suis. Ca n’est qu’un voeu pieux.

[2] Je n’ai pas été sans noter que le filon callovo-oxfordien où se situe le projet CIGEO présente un pendant de plus d’un degré en direction du nord ouest, c’est à dire du … Bassin Parisien.

[3] Je remarque au passage que CIGEO n’a nullement été conçu pour stocker les déchets qui seront issus du MOX (combustible nucléaire constitué d’environ 7 % de plutonium et 93 % d’uranium appauvri).

[4] La bentonite est très largement utilisée dans les travaux de construction, le forage des tunnels, du fait de sa capacité de colmatage et d’étanchéification de coffrages. http://fr.wikipedia.org/wiki/Bentonite

[5] Du moins sur des échelles de temps considérable. En effet le diamant tend à se transformer en graphite, qui est une forme carbonée plus stable, mais en un temps excédant l’âge de l’univers.

[6] La conductivité thermique de l’argilite du callovo-oxfordien du site d’enfouissement de Bure est de 1,3 à 2,7 W/m/°K. Source : http://fr.wikipedia.org/wiki/Laboratoire_de_Bure#S.C3.A9lection_du_site_de_Bure

[8] Pendant combien de temps et sur la base de quelle source d’énergie ?

[10] http://www2.equipement.gouv.fr/cetu/Securite/Présentation_18-03-2004/methodes_analyse_beton.pdf

[11] Source : Bruno Tarride, professeur à l’Institut National des Sciences et Techniques Nucléaires : Physique, fonctionnement et sûreté des réacteurs à eau pressurisée. Maîtrise des situations accidentelles du réacteur. http://books.google.fr/books?id=4cU2AAAAQBAJ&pg=PA213&lpg=PA213&dq=tenue+en+température+du+béton%2Bcorium&source=bl&ots=_MluGEb8x_&sig=gx5sp-pEbVPuTfkOp-g3NP2SUPw&hl=fr&sa=X&ei=Bu_XUrSpNqTI0AXduYHoAw&ved=0CE8Q6AEwBQ#v=onepage&q=tenue%20en%20température%20du%20béton%2Bcorium&f=false

[12] Les experts avaient assuré que ce dôme de sel présentait une stabilité garantie sur des millions d’années, conclusion chaudement approuvée par le député Bataille. Certes, … à condition de ne pas créer des trous dedans ! Il en est de même pour le filon d’argile de Bure, considéré comme stable “depuis cent millions d’années”, sans ses futures galeries…

[16] Il en est hélas de même, aujourd’hui, pour le développement de la fusion aneutronique, sous le couvert du secret défense, au USA et en Russie.

[17] La fusion deuterium-tritium n’est qu’une réaction de fusion parmi une foule d’autres. C’est simplement celle qui nécessite la température la plus basse.